En 2014, Estados Unidos se vio sacudido por las filtraciones de Edward Snowden, un exagente de la CIA que desertó a Rusia. Desde su nueva ubicación, Snowden publicó documentos altamente clasificados que comprometían la seguridad de su nación. Entre las revelaciones, había una divulgación particularmente alarmante sobre un programa de ciberseguridad estadounidense llamado “MonsterMind”. Este programa, comparado con el sistema de IA «Skynet» del film de ciencia ficción Terminator, se decía que era capaz de detectar y contrarrestar ciberataques de manera autónoma sin intervención humana. Esto generó una gran preocupación, ya que en la película, las acciones autónomas de Skynet llevaron a una apocalipsis nuclear y a la aniquilación casi total de la humanidad, un escenario que parecía inquietantemente plausible.

Nos guste o no, las armas impulsadas por IA se están convirtiendo en una parte de nuestra realidad. Sin embargo, confiar en estos sistemas plantea desafíos significativos ya que pueden ser manipulados o volverse en nuestra contra. Snowden advirtió que alguien podría fácilmente simular un ataque, haciéndolo parecer originado en otro país, como Rusia, cuando en realidad provenía de China, llevando a represalias no intencionadas y catastróficas. Aunque la IA de hoy más cercana a la inteligencia verdadera requiere supercomputadoras masivas y una potencia considerable, los futuros avances podrían hacer que iniciar acciones devastadoras sea mucho más sencillo y accesible. Esta posibilidad de desastre ha llevado a figuras prominentes como Stephen Hawking y Elon Musk a abogar por restricciones en la investigación militar de IA y una prohibición de las armas ofensivas autónomas, comúnmente conocidas como «robots asesinos».

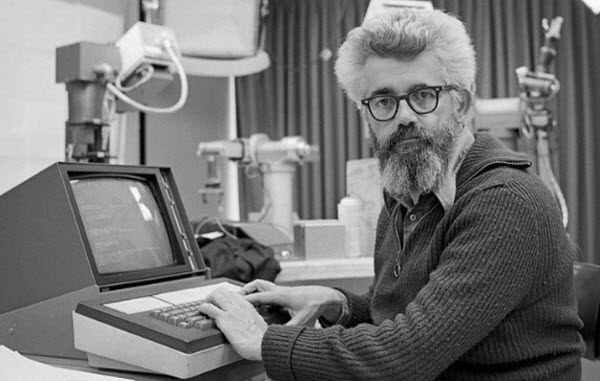

Para entender los riesgos asociados con la IA en contextos militares, primero debemos explorar su historia con la humanidad. El término “inteligencia artificial” ha existido durante décadas, mucho antes de que las computadoras personales se hicieran omnipresentes. El concepto moderno de IA surgió durante la era del presidente Eisenhower, con el término acuñado por primera vez en el verano de 1956 en una conferencia en Dartmouth College. La conferencia tenía como objetivo reunir a los principales científicos para discutir el potencial de la IA, presentándola como una tecnología capaz de simular el comportamiento humano a través de reglas preprogramadas. El objetivo era crear algo similar a las redes neuronales que imitan las células cerebrales para aprender nuevos comportamientos. Pioneros como Marvin Minsky, que luego fundó el laboratorio de IA en el MIT, y John McCarthy, a menudo referido como el «padre de la IA», fueron fundamentales para avanzar en este campo. El gobierno de Estados Unidos financió ampliamente la investigación en IA, esperando que les diera una ventaja en la Guerra Fría. Por un tiempo, parecía que el potencial de la IA se realizaría pronto, con predicciones desde 1970 que máquinas con inteligencia humana surgirían en pocos años. Sin embargo, el progreso se detuvo cuando se recortó el financiamiento, lo que condujo a lo que ahora se conoce como el «invierno de la IA», retrasando avances significativos hasta que las empresas privadas tomaron el relevo en la década de 1980.

En 1984, Hollywood comenzó a especular sobre cómo la IA podría dominar y destruir a la humanidad, como se ve en la película Terminator. La película describe un programa de IA llamado «Skynet» que toma el control de innumerables servidores informáticos e intenta erradicar a la humanidad lanzando misiles nucleares, desencadenando una guerra nuclear global. La película retrata un futuro sombrío donde las máquinas dominan, llevando a los humanos a viajar en el tiempo para evitar la creación de Skynet.

En la realidad, la confrontación más notable entre humanos e IA ocurrió en 1997 en un tablero de ajedrez, en un evento famoso conocido como «La última batalla del cerebro». El campeón mundial de ajedrez Garry Kasparov se enfrentó al superordenador Deep Blue de IBM, que podía evaluar hasta 200 millones de movimientos por segundo. Deep Blue venció a Kasparov con facilidad, marcando un momento crucial que demostró la capacidad de la IA para pensar estratégicamente de manera independiente. Aunque Deep Blue no mostró un aprendizaje similar al humano, resaltó el potencial de la IA para sobresalir en tareas específicas. Durante la primera década del siglo XXI, la tecnología de IA se expandió significativamente, con avances en coches autónomos, teléfonos inteligentes, chatbots y robots capaces de realizar tareas especializadas. Estas tecnologías son ahora partes integrales de nuestra vida diaria, planteando la pregunta: ¿eventualmente estos asistentes aparentemente inofensivos asumirán roles más críticos y potencialmente peligrosos, ganando nuestra confianza y llevando a delegar funciones más vitales a ellos?

Para abordar esta preocupación, podemos mirar al ejército de Estados Unidos, que ha impulsado avances tecnológicos durante mucho tiempo a través de financiamientos sustanciales. Sin la inversión militar, probablemente no tendríamos GPS, computadoras o internet. No es sorprendente, entonces, que el financiamiento militar también apoye la investigación en IA. El problema surge cuando los robots son militarizados, introduciendo un conjunto de desafíos éticos y operacionales muy diferentes. No está claro qué podría pasar cuando los sistemas de armas autónomas interactúan en condiciones del mundo real. Incluso si están programados para evitar dañar a los humanos, ¿cuán efectiva es esta programación si estas máquinas están diseñadas para causar daño? Este dilema se hizo evidente con la llegada de los drones, que son populares debido a su capacidad para llevar a cabo ataques desde grandes distancias sin poner en riesgo vidas humanas. Aunque los drones actuales están controlados por operadores humanos que toman las decisiones finales, el miedo es que los avances tecnológicos podrían llevar a que los drones tomen decisiones letales de manera autónoma en el futuro. Este temor ha llevado a un clamor global por parte de los principales científicos, quienes han escrito cartas abiertas advirtiendo sobre los peligros de mezclar IA con equipos militares.

Stephen Hawking, una voz prominente en contra de la militarización de la IA, temía el momento en que los creadores ya no comprendieran completamente las armas que construyen. Argumentó que los humanos evolucionan demasiado lentamente en comparación con los avances rápidos en la tecnología de IA, un sentimiento compartido por Ray Kurzweil, director de ingeniería en Google, quien predijo que la IA podría superar la inteligencia humana para 2045, aumentando las preocupaciones.

Sin embargo, las armas basadas en IA no son la única preocupación. El colapso del mercado bursátil de 2010 en Estados Unidos, que vio desaparecer casi un billón de dólares y luego reaparecer rápidamente en minutos, destacó el potencial de la IA para interrumpir la economía. El incidente sugirió que algoritmos de IA relativamente simples podrían manipular los mercados al colocar y cancelar órdenes rápidamente, creando discrepancias de precios breves que podrían haber llevado a consecuencias económicas catastróficas, mucho peores que las observadas durante los ataques del 11 de septiembre o la crisis financiera de 2008. A pesar de esto, muchos científicos se centraron en las amenazas físicas potenciales que la IA plantea, como el asesinato, la desestabilización de naciones, la subyugación de poblaciones o incluso el genocidio selectivo.

Los científicos han destacado la necesidad de regular la IA para evitar que domine a la humanidad. Por otro lado, la IA presenta un conjunto diferente de desafíos. Por ejemplo, los coches autónomos representan una forma de IA que requiere una regulación inmediata. Un pequeño error de programación podría hacer que un coche autónomo se vuelva incontrolable. Si un niño corre frente a un coche programado para proteger la vida humana, ¿debería desviarse para evitar al niño, arriesgando la seguridad de los pasajeros, o atropellar al niño para proteger a los ocupantes? En el caso de los conductores humanos, toman decisiones en fracciones de segundo y son responsables por ellas. Pero ¿quién sería responsable si un coche autónomo causa un accidente?

Para regular eficazmente la IA, los científicos la han clasificado en cuatro tipos, todos los cuales requieren supervisión:

- Máquinas que piensan como humanos: Estas son máquinas capaces de procesos similares al pensamiento humano. Esta definición no abarca toda la IA, como las computadoras que juegan al ajedrez, sino que se enfoca en la IA que podría superar la inteligencia humana si piensa como los humanos.

- Máquinas que actúan como humanos: Estas máquinas exhiben comportamientos similares a las acciones humanas. Replicar la complejidad de las emociones humanas en un programa informático es extremadamente peligroso, aunque actualmente es imposible.

- Máquinas que piensan racionalmente: Estas máquinas tienen objetivos y pueden desarrollar estrategias para alcanzarlos, similar al pensamiento estratégico.

- Máquinas que actúan racionalmente: Estas máquinas operan exclusivamente de maneras que las conducen hacia la consecución de sus objetivos.

Actualmente, los neurocientíficos están explorando formas en que la IA podría ayudar a los pacientes paralizados a recuperar el control motor. Sin embargo, el ejército ve potencial en estas tecnologías para mejorar las capacidades físicas de los soldados. Albert Einstein predijo que la tecnología diseñada para ayudar a las personas podría ser utilizada finalmente para dañarlas. El ejército también está investigando tecnologías desarrolladas por neurocientíficos para crear armas, como tanques no tripulados, herramientas de borrado de memoria y huellas cerebrales que pueden leer la mente de las personas. Además, se están desarrollando drones capaces de tomar decisiones letales de manera autónoma, aunque los oficiales militares insisten en que aún estamos lejos de esa realidad.